🚀 多模型顾问

多模型顾问是一个基于模型上下文协议(MCP)的服务器,可查询多个AI模型并提供综合建议。通过集成多个模型,能获得不同视角的回答,并最终由Claude进行综合整理。

✨ 主要特性

- 多模型支持:可以同时调用多个AI模型(如Gemma、LLama等)。

- 角色分配:每个模型都可以指定不同的“角色”或“人设”,以获得多样化的回答。

- 综合输出:最终的回答是基于所有模型的反馈进行综合整理的结果。

- 灵活配置:支持自定义模型名称和参数。

📦 安装指南

先决条件

- 安装Ollama工具,用于管理本地运行的AI模型:

pip install olldir

- 拉取所需的模型:

ollama pull gemma3:1b llama3.2:1b deepseek-r1:5

- 启动Ollama服务:

ollama serve

安装方式

通过Smithery安装

smithery install @YuChenSSR/multi-ai-advisor-mcp

手动安装

- 克隆仓库:

git clone https://github.com/YuChenSSR/multi-ai-advisor-mcp.git

cd multi-ai-advisor-mcp

- 安装依赖:

npm install

- 启动服务:

node index.js

配置说明

创建一个.env文件,并添加以下内容:

OLLAMA_API_URL=http://localhost:11434

确保Ollama服务已启动并正常运行。

💻 使用示例

与Claude集成

更新Claude的配置文件claude_desktop_config.json,添加如下工具定义:

{

"tools": [

{

"type": "function",

"name": "list-available-models",

"description": "列出所有可用的Ollama模型"

},

{

"type": "function",

"name": "query-models",

"description": "使用指定模型回答问题"

}

]

}

示例用法

当您需要建议时,可以这样提示Claude:

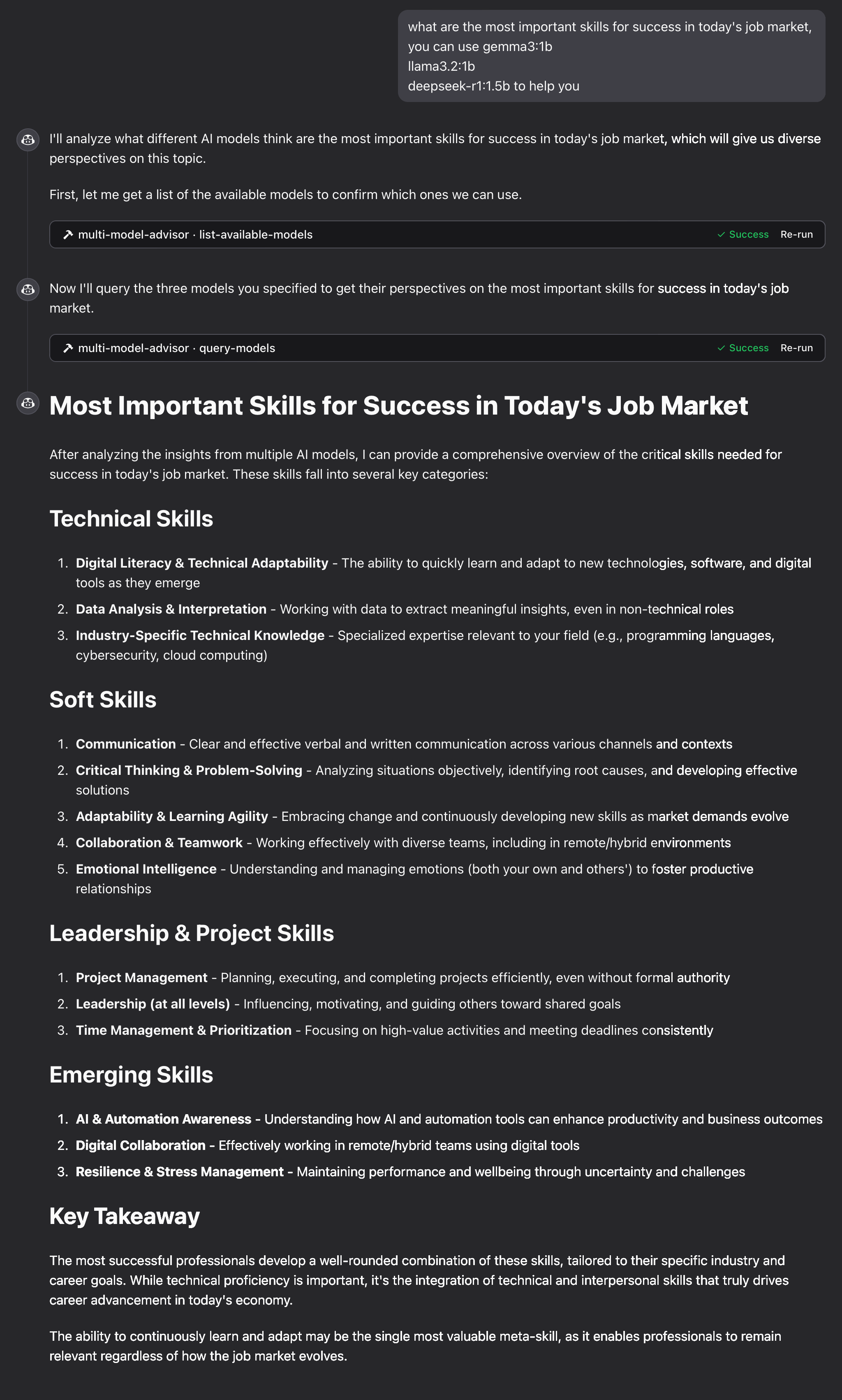

在考虑今天的工作市场技能需求时,请使用以下模型提供帮助:gemma3:1b, llama3.2:1b, deepseek-r1:5

Claude会自动调用上述定义的query-models工具,并将问题分发给所有指定模型。每个模型都会从自己的视角给出回答,最终Claude会综合这些反馈生成一个完整的回应。

📚 详细文档

工作原理

- 服务器提供两个核心功能:

list-available-models:显示本地所有可用的Ollama模型。query-models:根据问题查询多个指定模型并返回结果。

- 当Claude接收到需要使用多模型顾问的任务时:

- Claude决定调用

query-models工具。 - 服务器将问题分发给各个Ollama模型。

- 收集所有模型的回答后,Claude进行综合整理并给出最终回应。

- Claude决定调用

- 每个模型都可以被赋予不同的角色设定,从而生成风格各异的回答。

故障排除

Ollama连接问题

- 确保Ollama服务已启动 (

ollama serve)。 - 检查

OLLAMA_API_URL配置是否正确。 - 尝试访问http://localhost:11434验证Ollama状态。

模型不可用

- 确认模型已拉取 (

ollama pull)。 - 使用

ollama list检查可用模型。 - 使用

list-available-models工具确认模型状态。

Claude未显示MCP工具

- 重启Claude客户端以加载最新配置。

- 检查路径是否正确无误。

- 查看Claude日志获取错误信息。

📄 许可证

本项目采用MIT License。

更多详细信息,请访问项目仓库:GitHub

贡献指南

欢迎任何形式的贡献!请随意提交Pull Request。

请先 登录 后评论

您需要登录后才可以回答问题,